В фильме «Лучший стрелок: Индивидуалист» Мэверику, которого играет Том Круз, поручено обучать молодых пилотов выполнению, казалось бы, невыполнимой миссии — вести свои реактивные самолеты глубоко в скалистый каньон, оставаясь так низко над землей, что их невозможно обнаружить радаром, а затем быстро подниматься из каньона под экстремальным углом, избегая каменных стен. Предупреждение о спойлере: С помощью Маверика эти пилоты-люди выполняют свою миссию.

Машина, с другой стороны, с трудом справилась бы с такой же трудоемкой задачей. Например, для автономного летательного аппарата самый прямой путь к цели противоречит тому, что машина должна делать, чтобы избежать столкновения со стенами каньона или остаться незамеченной. Многие существующие методы искусственного интеллекта не способны преодолеть этот конфликт, известный как проблема стабилизации-избегания, и не смогли бы безопасно достичь своей цели.

Исследователи Массачусетского технологического института разработали новую методику, которая может решать сложные проблемы стабилизации и предотвращения лучше, чем другие методы. Их подход к машинному обучению соответствует или превосходит безопасность существующих методов, обеспечивая при этом десятикратное повышение стабильности, что означает, что агент достигает своей целевой области и остается стабильным в ней.

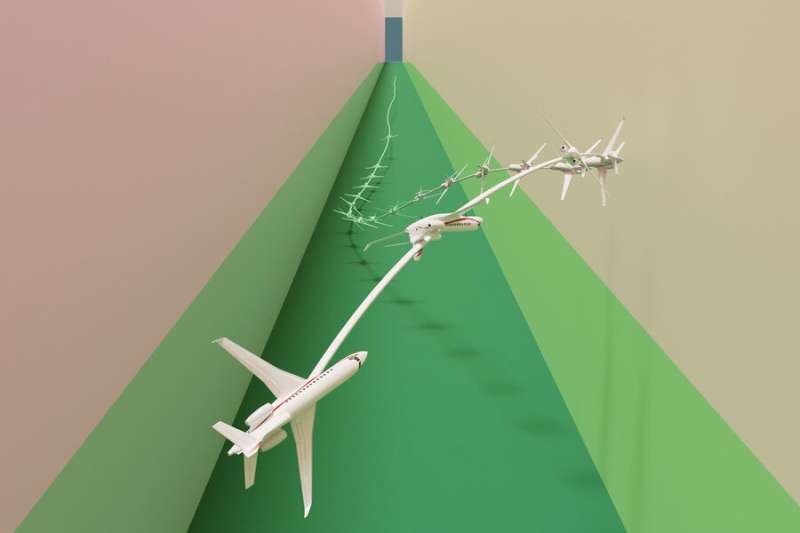

В эксперименте, которым мог бы гордиться Maverick, их техника эффективно провела имитацию реактивного самолета по узкому коридору, не врезавшись в землю.

«Это была давняя, сложная проблема. Многие люди смотрели на это, но не знали, как справиться с такой многомерной и сложной динамикой», — говорит Чучу Фан, доцент кафедры аэронавтики и астронавтики университета Уилсона, сотрудник Лаборатории информационных систем и систем принятия решений (LIDS) и старший автор новой статьи по этому вопросу. техника.

К Fan присоединился ведущий автор Освин Со, аспирант. Статья будет представлена на конференции «Робототехника: наука и системы», которая состоится 10-14 июля в Корее. Документ доступен на сервере предварительной печати arXiv.

Это видео показывает, как исследователи использовали свою технику для эффективного управления имитируемым реактивным самолетом в сценарии, когда он должен был стабилизироваться на цели вблизи земли, сохраняя при этом очень низкую высоту и оставаясь в пределах узкого коридора полета. Источник: Массачусетский технологический институт

Задача стабилизировать-избежать

Многие подходы решают сложные проблемы, позволяющие избежать стабилизации, упрощая систему, чтобы ее можно было решить с помощью простой математики, но упрощенные результаты часто не соответствуют динамике реального мира.

Более эффективные методы используют обучение с подкреплением, метод машинного обучения, при котором агент учится методом проб и ошибок, получая вознаграждение за поведение, которое приближает его к цели. Но на самом деле здесь есть две цели — оставаться стабильным и избегать препятствий, — и поиск правильного баланса утомителен.

Исследователи Массачусетского технологического института разбили проблему на два этапа. Во-первых, они переосмысливают проблему стабилизации-избегания как проблему ограниченной оптимизации. В этой настройке решение задачи оптимизации позволяет агенту достичь своей цели и стабилизироваться на ней, что означает, что он остается в пределах определенного региона. Применяя ограничения, они гарантируют, что агент избежит препятствий, объясняет So.

Затем, на втором этапе, они переформулируют эту задачу ограниченной оптимизации в математическое представление, известное как форма эпиграфа, и решают ее, используя алгоритм глубокого обучения с подкреплением. Форма эпиграфа позволяет им обойти трудности, с которыми сталкиваются другие методы при использовании обучения с подкреплением.

«Но глубокое обучение с подкреплением не предназначено для решения задачи оптимизации в виде эпиграфа, поэтому мы не могли просто подключить его к нашей задаче. Нам нужно было вывести математические выражения, которые работают для нашей системы. Как только у нас появились эти новые выводы, мы объединили их с некоторыми существующими инженерными приемами, используемыми другими методами», — говорит Со.

Нет очков за второе место

Чтобы проверить свой подход, они разработали ряд контрольных экспериментов с различными начальными условиями. Например, в некоторых симуляциях автономному агенту необходимо достичь целевой области и оставаться внутри нее, совершая резкие маневры, чтобы избежать препятствий, которые находятся на пути столкновения с ним.

По сравнению с несколькими исходными условиями, их подход был единственным, который мог стабилизировать все траектории при сохранении безопасности. Чтобы продвинуть свой метод еще дальше, они использовали его для управления имитацией реактивного самолета по сценарию, который можно было бы увидеть в фильме «Лучший стрелок». Реактивный самолет должен был стабилизироваться на цели вблизи земли, сохраняя при этом очень низкую высоту и оставаясь в пределах узкого коридора полета.

Эта имитационная модель реактивного самолета появилась в открытом доступе в 2018 году и была разработана экспертами по управлению полетом в качестве тестовой задачи. Могли бы исследователи создать сценарий, при котором их контроллер не смог бы летать? Но модель была настолько сложной, что с ней было трудно работать, и она все еще не могла справиться со сложными сценариями, говорит Фан.

Контроллер исследователей Массачусетского технологического института смог предотвратить крушение или пробуксовку самолета, стабилизируя его на заданном уровне гораздо лучше, чем любой из исходных показателей.

В будущем эта технология может стать отправной точкой для разработки контроллеров для высокодинамичных роботов, которые должны соответствовать требованиям безопасности и стабильности, таких как автономные дроны-доставщики. Или это могло бы быть реализовано как часть более крупной системы. Возможно, алгоритм активируется только тогда, когда автомобиль заносит на заснеженной дороге, чтобы помочь водителю безопасно вернуться на стабильную траекторию.

Управление экстремальными сценариями, с которыми человек был бы не в состоянии справиться, — вот где их подход действительно блестящ, добавляет So.

«Мы считаем, что цель, к которой мы должны стремиться как специалисты в данной области, состоит в том, чтобы предоставить усиленному обучению гарантии безопасности и стабильности, которые понадобятся нам при развертывании этих контроллеров в критически важных системах. Мы считаем, что это многообещающий первый шаг к достижению этой цели», — говорит он.

Двигаясь вперед, исследователи хотят усовершенствовать свою методику, чтобы она лучше учитывала неопределенность при решении задачи оптимизации. Они также хотят исследовать, насколько хорошо алгоритм работает при развертывании на аппаратном обеспечении, поскольку будут наблюдаться несоответствия между динамикой модели и динамикой реального мира.

«Команда профессора Фана улучшила эффективность обучения с подкреплением для динамических систем, где важна безопасность. Вместо того чтобы просто достигать цели, они создают контроллеры, которые гарантируют, что система сможет безопасно достичь своей цели и оставаться там неопределенно долго», — говорит Стэнли Бак, доцент кафедры компьютерных наук Университета Стоуни Брук, который не принимал участия в этом исследовании. «Их улучшенная формулировка позволяет успешно создавать безопасные контроллеры для сложных сценариев, включая нелинейную модель реактивного самолета с 17 состояниями, частично разработанную исследователями из исследовательской лаборатории ВВС (AFRL), которая включает нелинейные дифференциальные уравнения с таблицами подъемной силы и лобового сопротивления».